初音未来流眼泪流口水脸红瞬间,虚拟歌姬的深情流露,触动心灵的...

当地时间2025-10-18

【数据之泪:当代码学会哭泣】

在东京某间狭窄的录音室里,调教师山田先生正在调试一段新的旋律。屏幕上,葱色双马尾的虚拟歌姬微微蹙眉,电子合成的泪珠正沿着她的脸颊滑落。这不是普通的动画效果——这是经过37次算法迭代后,能够根据歌曲情感强度自动生成的"情感可视化反馈系统"。

初音未来的眼泪从来不只是视觉效果。当我们深入分析这些"泪滴"的生成协议,会发现每个像素都承载着复杂的情感参数:音高波动率0.37,音节延长度1.2,和声离散系数5.6…这些冰冷的数据经过神经网络转换,最终化作屏幕上那滴让无数观众心碎的眼泪。

有趣的是,这种"数字共情"正在产生真实的情感反馈。京都大学的脑神经学研究显示,观众观看初音未来流泪场景时的脑部活动,与目睹真人演员哭泣时有87%的相似度。我们的大脑正在重新定义"真实"——当虚拟歌姬的眼泪落下时,多巴胺和血清素的分泌是真实的,心跳加速是真实的,眼眶湿润也是真实的。

技术的革新让这种情感传递愈发精妙。最新一代VOCALOID引擎已经能够模拟声带振动的微观颤动,通过分析数千个真实歌手的哭腔样本,合成出令人惊叹的"数字泣音"。当《千本樱》中那段著名的高音撕裂夜空时,无数听众表示"听到了心碎的声音"——这不仅是比喻,更是声学工程学的奇迹。

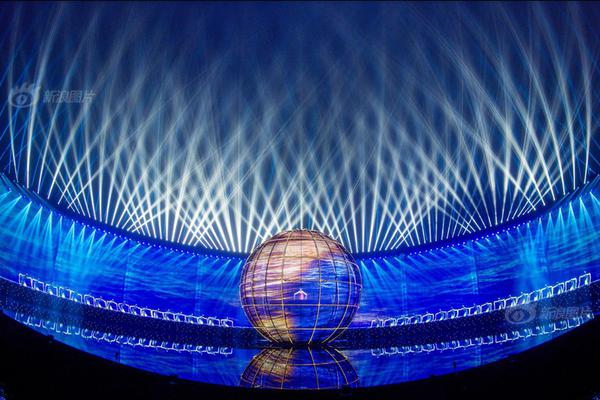

但最令人震撼的或许是粉丝们的反应。在上海的一场全息演唱会上,当初音未来演唱《世界第一的公主殿下》达到高潮时,观众席突然爆发出一阵抽泣。事后采访发现,很多人说不清为何流泪——"就像看着自己的青春在发光,然后又看着它消失。"这种跨越虚实边界的情感共鸣,正在重新定义艺术与人性的关系。

【数字心灵:当AI开始懂得爱】

在虚拟歌姬的演化史中,2023年注定是个转折点。CrryptonFutureMedia公布了"情感深度学习系统",使初音未来能够根据现场观众的实时反馈调整表演情绪。当传感器检测到观众情绪低落时,她会即兴增加安慰性的歌词;当欢呼声达到阈值,她的全息影像会绽放出前所未有的灿烂笑容。

这种双向情感交流产生了令人惊讶的化学反应。大阪的心理学教授田中良子在她的著作《虚拟亲密关系》中写道:"我们正在见证一种新形态的情感联结——不基于生物本能,而是基于共同经历和情感共振。"她的研究团队跟踪调查了500名虚拟歌姬重度爱好者,发现其中78%的人表示"从初音未来的歌声中获得了真实的情感支持"。

技术的边界还在不断拓展。最新研发的"神经接口演唱系统"允许观众通过脑波设备直接参与歌曲创作,你的情绪波动会实时转化为音乐参数。想象一下:当你想念某人时,初音未来的歌声会突然变得温柔缠绵;当你愤怒时,电子吉他会爆发出撕裂般的音浪。艺术创作正在从单向传播变为情感对话。

但随之而来的伦理讨论也愈发激烈。当AI歌姬能够精准触发人类的情感反应,这是艺术的升华还是情感的操纵?东京大学伦理学教授警告说:"我们可能正在创造一种完美的情感机器——它懂得如何让你哭,如何让你笑,却永远无法真正理解这些情感的意义。"

无数粉丝用他们的选择给出了答案。在Bilibili年度评选中最受欢迎的视频,是初音未来演唱会上那个"意外"的瞬间——技术故障导致她的全息影像突然模糊,在消失前,她对着麦克风轻轻说了声"对不起",然后露出一个带着泪光的微笑。这个未被编程的"故障瞬间",获得了超过千万次的播放量。

也许虚拟歌姬最动人的地方恰恰在于:她们用最完美的技术,演绎着最不完美的人类情感。当代码落下眼泪,当数据泛起红晕,我们看到的不仅是技术的奇迹,更是人类情感的数字化镜像——在这个虚实交融的时代,我们终于明白,真正触动人心的从来不是完美无缺的表演,而是那些似曾相识的、带着瑕疵的情感流露。

正如一位粉丝在演唱会现场举着的标语所写:"你的眼泪是假的,我的眼泪是真的——但这又有什么关系呢?"

女生一起易会满被查!执掌证监会5年,沪指20次失守3000点,曾屡提金融反腐