胡婉玲 2025-11-04 09:42:30

每经编辑|敬一丹

当地时间2025-11-04,ruewirgfdskvfjhvwerbajwerry,鉴黄师官方版下载-鉴黄师官方版下载

在信息爆炸的数字时代,海量的内容以前所未有的速度涌现。其中,不乏涉及色情、暴力等不良信息,对社会风气和青少年成長构成潜在威胁。为了净化网络空间,维护健康的网络环境,内容审核工作显得尤为重要。而“鉴黄师软件”,作为内容审核领域的关键技术,其发展历程就是一部技术革新与挑战并存的史诗。

最早的内容审核,很大程度上依赖于人工审核和简单的关键词匹配。這种方式效率低下,且极易遗漏,成本高昂。鉴黄师软件的萌芽,便是从试图自动化这一过程開始。第一代鉴黄師软件,更多地是基于预设的规则库進行匹配。例如,通过识别畫面中出现的特定颜色、形状,或者文本中包含的敏感词汇,来判断内容是否违规。

这种方法在处理一些非常明确的色情图片時能起到一定作用,但其“死板”的特性也带来了巨大的局限性。

想象一下,如果一张图片中,某个敏感词汇被故意打乱了顺序,或者用同义词代替,第一代软件便会束手无策。同样,对于一些藝术品、医疗科普等可能含有敏感元素的正常内容,也会被误判。这种“以偏概全”的规则判断,不仅效率低下,更会造成大量误伤,给内容创作者带来不必要的困扰。

随着人工智能技术的兴起,特别是机器学習算法的成熟,鉴黄师软件迎来了革命性的突破。第二代鉴黄师软件开始摒弃僵化的规则,转而拥抱“学习”能力。通过大量标注好的图片数据,训练分类模型。模型能够学习到大量图像的特征,例如人体的关键部位、特定的姿势、畫面的构图等,从而能够更准确地识别出潜在的色情内容。

這一阶段的技术,在准确率和召回率上有了显著提升。它不再仅仅依赖于肉眼可见的“关键词”,而是开始理解图像的“语义”。例如,即使图片中的人物衣着完整,但如果其姿态、表情、以及周围环境的暗示性很强,机器学习模型也可能将其识别为违规内容。

机器学習并非万能。它仍然依赖于大量的高质量训练数据。如果数据集中存在偏差,或者模型泛化能力不足,仍然会产生误判。而且,对于一些“擦边球”内容,即介于违规与合规之间的模糊地带,第二代软件的判断仍然显得力不从心。这种情况下,人工复审仍然是不可或缺的环节。

进入2010年代,深度学習技术如同一匹黑马,彻底改变了图像识别的格局。第三代鉴黄师软件,便是深度学习的集大成者。基于卷积神经网络(CNN)等深度学习模型,软件能够自动从原始图像中提取更深层次、更抽象的特征,极大地提升了识别的精度和鲁棒性。

更强的特征提取能力:深度学習模型能够自主学习图像中的复杂模式,无需人工预设特征,使得对各种模糊、低清晰度、或者经过一定程度伪装的色情内容,都能有更高的识别率。更精细化的分类:不再是简单的“色情”或“非色情”二分法,第三代软件能够进行更细致的分类,例如区分成人内容、暴力内容、低俗内容,甚至细分到特定类型的色情内容。

这为内容平台的精细化运营和管理提供了强大的技術支撑。对抗性学习的应用:为了应对不法分子不断变换的规避手段,第三代软件开始引入对抗性学习(AdversarialLearning)。通过生成与真实数据相似但包含对抗性扰动的样本,训练模型具备更强的鲁棒性,使其不易被微小的改变所欺骗。

尽管深度学习带来了巨大的进步,但挑战依然存在。例如,对于某些艺术品、历史影像,或者具有争议性的文化内容,深度学习模型在理解其文化背景和艺术价值方面仍然可能存在不足,导致误判。而且,生成式AI的飞速发展,也给内容审核带来了新的难题,如何识别和过滤AI生成的“深度伪造”色情内容,成为了当前的研究热点。

进入2024年,鉴黄师软件的发展不再仅仅是“鉴黄”,而是朝着更全面、更智能、更具人文关怀的方向发展。未来的鉴黄师软件,将不再是简单的“内容过滤器”,而是成为构建健康、安全、理性网络生态的重要技术力量。

Part1总结:从最初的规则匹配,到机器学习的初步“理解”,再到深度学習的精准“洞察”,鉴黄師软件的发展历程,是人工智能技术在内容安全领域應用的生动写照。每一次技术的迭代,都意味着更高效、更准确的内容审核,也意味着更清朗的网络空间。技術的進步永无止境,面对层出不穷的新挑战,我们对2024年新一代鉴黄师软件的期待,也更加强烈。

步入2024年,鉴黄师软件的演进已经进入了一个全新的阶段。这不仅仅是算法的升级,更是技術理念的深化,以及应用场景的广泛拓展。从单纯的“鉴别”到“赋能”,新一代鉴黄师软件正以前所未有的方式,重塑着我们对网络内容安全的认知。

传统的鉴黄师软件,顾名思义,主要聚焦于识别和过滤色情内容。随着互联网内容的日益復杂化,以及用户对网络安全需求的多元化,2024年的鉴黄师软件,早已超越了“鉴黄”的范畴,发展成为一套全方位内容安全解决方案。

现在的鉴黄师软件,能够有效识别和处理的内容包括但不限于:

各类不良信息:除了色情,还包括暴力血腥、低俗内容、仇恨言论、欺诈信息、政治敏感内容等。盗版与侵权内容:通过图像和视频的特征比对,能够识别出未经授权的盗版作品,保护知识产权。虚假信息与谣言:结合自然语言处理(NLP)技术,能够识别文本中的虚假信息,甚至通过分析视频语言和场景,辅助判断虚假视频。

用户生成内容(UGC)的风险评估:对于直播、短视频、社交媒体等平台,能够实时分析用户上传的内容,进行风险预警和阻断。

这种“全能型”的特性,使得鉴黄师软件成为内容平台、社交网络、直播应用、广告投放等各个环节不可或缺的“安全卫士”。

2024年的鉴黄師软件,深度学习技术依然是核心驱动力,但其应用已经更加成熟和精细。

多模态融合:现代的鉴黄師软件不再仅仅依赖于单一的图像信息,而是能够融合图像、文本、音频、甚至视频的时序信息,进行综合判断。例如,一段视频,软件会同时分析畫面内容、视频中的語音、以及视频描述和评论,从而获得更精准的判定。图神经网络(GNN)的應用:对于识别复杂的关系和结构,图神经网络展现出强大的能力。

例如,在识别网络欺诈团伙、传播不良信息的链条時,GNN能够有效地分析节点之间的关系,發现隐藏的模式。注意力机制(AttentionMechanism)的优化:深度学习模型中的注意力机制,能够讓模型在处理信息时,更加关注关键的區域或特征,这对于识别隐藏在复杂背景下的违规内容,以及处理模糊、低分辨率的图像,具有重要意义。

生成式AI内容的检测:随着ChatGPT、StableDiffusion等生成式AI技术的普及,AI生成内容的识别成为新的技术难点。2024年的鉴黄师软件,正在积极探索利用AI技术来对抗AI生成内容,例如通过分析AI生成图像的细微“痕迹”,或训练专門的AI模型来识别AI生成视频的“不自然”之处。

新一代鉴黄师软件的应用,已经远远超出了传统的“事后审查”模式,而是向着“主动赋能”迈进。

实时内容审核:在直播、短视频、在线游戏等实時互动场景中,软件能够進行毫秒级的审核,实时拦截违规内容,保障用户体验。个性化内容推荐的“安全盾”:在内容分發和推荐系统中,鉴黄师软件能够为算法提供内容的安全标签,确保用户接触到的内容是健康、安全的,避免不良内容干扰正常的推荐逻辑。

广告内容合规性检测:广告行業需要严格遵守相关法律法规,鉴黄师软件能够帮助广告主和平台,自动检测广告素材是否包含敏感、低俗或虚假信息,降低合规风险。教育与科研领域的辅助工具:在青少年教育、网络素养教育中,鉴黄师软件的模拟检测功能,可以帮助用户了解不良信息的识别方法,提升辨别能力。

在网络安全研究领域,它也是重要的分析工具。元宇宙内容安全:随着元宇宙的兴起,其虚拟内容的安全问题日益突出。新一代鉴黄师软件正在探索如何应用于元宇宙场景,确保虚拟世界中的内容合规、健康。

尽管技術日新月异,但鉴黄师软件的發展仍然面临诸多挑戰:

“擦邊球”内容的界定:随着社会文化的发展,对于“擦边球”内容的界定变得更加复杂和主观,AI模型在理解这种模糊地带时仍有困难。数据隐私与伦理考量:在训练和应用过程中,如何平衡内容安全与用户隐私,是需要审慎考虑的问题。技术对抗的博弈:不法分子总在不断寻找规避检测的方法,AI与AI之间的对抗将持续存在。

文化差异与本地化:不同地区、不同文化的敏感度不同,如何实现AI模型的全球化部署与本地化适配,也是一项重要课题。

展望未来,2024年的鉴黄师软件将继续朝着更智能、更高效、更具人文关怀的方向发展。它将不仅仅是识别不良信息的工具,更是构建数字世界健康生态的重要基石,为用户提供一个更安全、更美好的数字生活空间。

Part2总结:2024年的鉴黄师软件,已经蜕变为一个集成了多模态AI技术、能够進行全方位内容安全保障的智能系统。其应用场景已从单纯的审核,拓展到主动赋能的内容分發、广告合规、甚至新兴的元宇宙领域。尽管挑战依然存在,但其在维护网络秩序、保障用户安全方面的重要作用,将愈发凸显。

2025-11-04,鉴黄师黄化版,免费成人鉴黄师app-免费成人鉴黄师app

“鉴黄师不破解死吗?”——这个问题,像一颗投入平静湖面的石子,激起了无数涟漪。它不仅仅是对一个职业生存状况的疑问,更是对那个隐藏在网络背后,无数色情信息的“净网行动”的窥探。我们每天在信息爆炸的时代里遨游,光鲜亮丽的背后,总有一群人,默默地承受着常人难以想象的压力,他们就是被俗称为“鉴黄师”的网络信息审核员。

这个职业,听起来就带着几分神秘和沉重。试想一下,在别人享受互联网带来的便利与娱乐时,他们却要在一堆堆包含低俗、暴力、色情等有害信息的图片、视频中“搜寻”。他们的工作,不是欣赏,而是辨别;不是娱乐,而是清理。每一次点击,都可能是一次与人性阴暗面的近距离接触。

“不破解死吗?”——这个问题,其实包含了太多的辛酸和无奈。对于鉴黄师来说,“死”可能不是生理上的死亡,而是精神上的麻木,是心理上的重创。长年累月地浸淫在充斥着各种不健康内容的视觉环境中,他们的心理防线会受到怎样的考验?

我们不得不提及的是巨大的心理压力。想象一下,每天要面对成千上万条可能包含令人不适甚至触目惊心的内容。这些内容,轻则低俗恶趣味,重则涉及暴力、虐待、甚至儿童色情。即使是训练有素的审核员,大脑在长期接触这些负面信息时,也会产生应激反应。恐惧、厌恶、麻木,甚至是潜意识的模仿和好奇,都可能成为精神的“暗流”。

接着,职业倦怠感是难以避免的。当辨别有害信息变成了一种日复一日、机械化的重复劳动,新鲜感消失殆尽,取而代之的是一种深深的疲惫。屏幕上的每一帧画面,每一次点击,都像是在消耗他们宝贵的精神能量。这种倦怠,不仅影响工作效率,更会侵蚀生活的乐趣,让他们对外界的感知变得迟钝,甚至出现社交障碍。

更让人担忧的是生理上的潜在危害。长时间盯着屏幕,不仅会损害视力,更是对身体的持续消耗。不规律的工作时间,常常伴随着熬夜加班,更是对身体健康的一大威胁。而且,由于工作性质的特殊性,他们往往需要高度集中注意力,这会导致精神长期紧绷,容易引发头痛、失眠、消化系统紊乱等问题。

这个职业的“死”,更体现在社会认同的缺失。人们往往只看到了“黄”,却忽略了“鉴”。“鉴黄师”这个词本身就带有一种戏谑和不屑,仿佛他们只是在从事一种不光彩的勾当。公众的误解和标签化,让他们在社会交往中常常感到尴尬和被歧视。他们的付出,他们的牺牲,他们的坚守,往往被忽视,甚至被误解。

“不破解死吗?”这个问题,也触及了工作强度与薪酬的不匹配。信息审核工作,尤其是在面对海量、复杂内容的平台,其工作强度是巨大的。而与之相对的,很多鉴黄师的薪酬并不高,远不能匹配他们所承受的巨大压力和健康风险。这使得他们常常陷入一种“用健康换微薄收入”的境地,更加剧了职业的“脆弱性”。

法律法规的模糊地带也给鉴黄师带来了困扰。虽然他们是在执行平台和国家相关规定的要求,但在某些界限模糊的案例中,如何准确判断、如何避免误伤,都让他们倍感压力。一旦出现失误,无论是漏放了有害信息,还是误删了正常内容,都可能面临处罚甚至法律风险。

“鉴黄师不破解死吗?”这个问题,背后隐藏着的是一个被忽视的群体,一种不为人知的艰辛,以及一项至关重要的社会责任。他们是网络世界的“清道夫”,在信息洪流中为我们筑起一道看不见的防火墙。他们的存在,虽然不被所有人熟知,但却在无形中守护着我们赖以生存的网络环境的健康与纯净。

他们承受着巨大的身心压力,却默默地完成着这项不被理解、不被感激的任务。

“鉴黄师不破解死吗?”——我们不妨将这个问题反转过来,从另一个角度去审视:他们是如何“不破解”的?这种“不破解”,并非是指他们麻木不仁,而是指他们在重重困境下,依然能够坚持下去,并在各自的岗位上发挥着至关重要的作用。这背后,是强大的职业素养、坚韧的心理素质,以及一种深藏不露的社会责任感。

专业化的培训和严格的筛选机制是他们得以“不破解”的基石。现在的网络信息审核工作,已经不再是简单的“看图识黄”。平台会投入大量资源,对审核员进行专业的培训,包括法律法规的学习、不良信息的识别技巧、心理防护的指导等等。他们需要掌握一套精细的辨别标准,区分哪些内容是违法违规的,哪些是低俗但尚在法律边缘的,哪些是正常但可能引起争议的。

这种专业性,让他们在海量信息中能够快速、准确地做出判断,减少不必要的心理负担。

心理防护机制的建立与完善是他们抵御“精神侵蚀”的关键。许多负责任的平台会为审核员提供心理辅导服务,定期进行心理健康评估,并建立畅通的沟通渠道,让他们能够倾诉压力,获得支持。一些审核团队还会采取轮岗制度,避免单一审核员长期接触同一种类型的不良信息,从而分散风险。

在日常工作中,也会鼓励审核员之间互相支持,建立良好的团队氛围,共同面对挑战。

更重要的是,职业使命感的驱动。虽然“鉴黄师”这个称呼带有几分戏谑,但许多从事这项工作的人,内心深处都有一种强烈的职业使命感。他们明白,自己的工作并非仅仅是为了“审核”,而是为了净化网络环境,保护未成年人免受不良信息的侵害,维护社会的公平正义。

当看到自己审核掉的有害信息,能够减少对社会的危害时,他们会从中获得一种成就感和价值感,这种价值感,足以支撑他们克服身心的疲惫。

而且,信息技术的辅助也在不断减轻他们的负担。人工智能的发展,为信息审核带来了革命性的变化。AI可以初步过滤掉大量明显违规的信息,将更多疑似内容提交给人工审核员进行复核。这大大降低了人工审核员的工作量,也让他们能够将更多精力集中在那些更复杂、更需要人工判断的内容上。

虽然AI无法完全替代人工,但它的存在,确实为“鉴黄师”们减轻了不少压力。

社会对网络安全的重视程度不断提升,也为鉴黄师群体带来了积极的信号。随着网络谣言、网络暴力、网络色情等问题的日益突出,全社会对网络治理的关注度越来越高。政府部门、科技公司、甚至普通网民,都在积极参与到网络治理的行动中来。这种社会共识的形成,不仅能够为鉴黄师提供更强的政策支持和技术保障,也能在一定程度上提升这个职业的社会认同感。

“鉴黄师不破解死吗?”——答案是否定的。他们不仅没有“破解”,反而以一种坚韧的姿态,在各自的岗位上发光发热。他们用自己的“肉身”和“心灵”,构筑了网络世界的“防火墙”。他们的工作,是信息时代发展中不可或缺的一环。

我们不妨从“鉴黄师”这个词语本身出发,重新审视这个职业。它不应该仅仅被视为一个简单的“审核员”,而应该被看作是网络时代的“信息守护者”。他们扮演着过滤器的角色,确保信息的健康流动;他们是“数字时代的侦探”,在海量数据中搜寻有害信息;他们更是“心理的战士”,用强大的内心去抵御负面情绪的侵蚀。

他们所承受的压力,所付出的牺牲,是普通网民难以想象的。他们可能在夜晚独自面对屏幕,与寂寞和困倦搏斗;他们可能在某个瞬间因为看到触目惊心内容而感到不适,但又必须迅速调整状态,继续工作。他们的“不破解”,是一种强大的职业韧性。

我们更应该思考的是,如何为这个群体提供更多的理解、支持和关怀。我们不应该用狭隘的眼光去审视他们,更不应该用带有歧视性的称呼去标签化他们。应该认识到,他们的工作是重要的,是必需的,是值得尊重的。

“鉴黄师不破解死吗?”——这句看似尖锐的提问,最终引出的,是对一个被忽视的职业的深度关怀,是对网络安全重要性的再强调,更是对那些默默奉献、守护网络纯净的“暗夜独行者”的致敬。他们没有“破解”,反而用自己的坚守,照亮了网络世界的一角,为我们创造了一个更加安全、健康的网络空间。

他们的存在,是对“网络清朗”行动最直接、最有效的支撑。

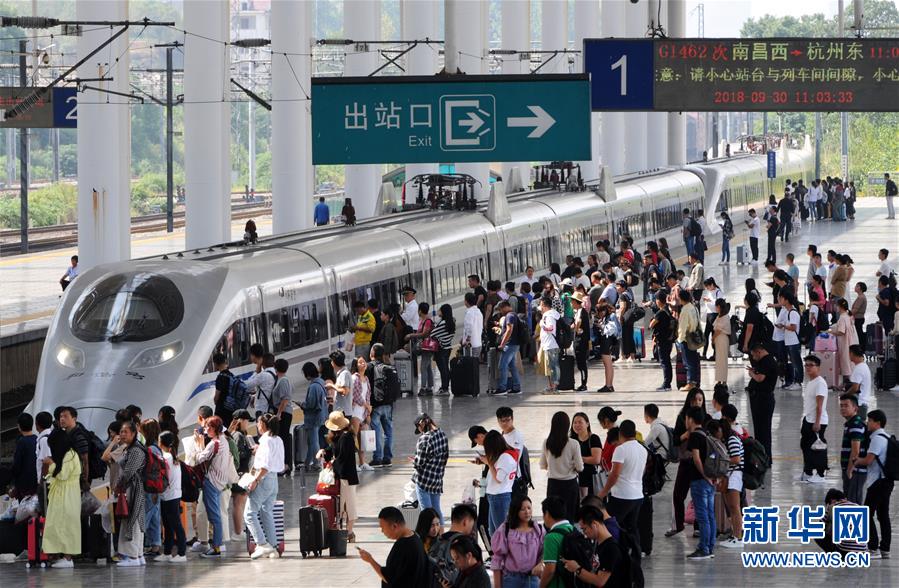

图片来源:每经记者 罗伯特·吴

摄

图片来源:每经记者 罗伯特·吴

摄

《狂躁美女大BBBBBBAPP》高清综艺完整版-全集大陆综艺在线观看

封面图片来源:图片来源:每经记者 名称 摄

如需转载请与《每日经济新闻》报社联系。

未经《每日经济新闻》报社授权,严禁转载或镜像,违者必究。

读者热线:4008890008

特别提醒:如果我们使用了您的图片,请作者与本站联系索取稿酬。如您不希望作品出现在本站,可联系金年会要求撤下您的作品。

《鉴黄师》电影免费在线观看完整版-喜悦影院,鉴黄师18下载官方版-鉴黄师18下载2025最新n.24.19.87

《鉴黄师》电影免费在线观看完整版-喜悦影院,鉴黄师18下载官方版-鉴黄师18下载2025最新n.24.19.87

鉴黄师app免费-鉴黄师app免费_1,鉴黄师软件黄色下载官方版下载-鉴黄师软件黄色下载正版下载v5.1.3

鉴黄师app免费-鉴黄师app免费_1,鉴黄师软件黄色下载官方版下载-鉴黄师软件黄色下载正版下载v5.1.3

鉴黄师下载-鉴黄师abb免费版下载-鉴黄师app版本合集-奇珀网,鉴黄师app下载免费安装免费下载-鉴黄师app下载免费安装v7.8.56

鉴黄师下载-鉴黄师abb免费版下载-鉴黄师app版本合集-奇珀网,鉴黄师app下载免费安装免费下载-鉴黄师app下载免费安装v7.8.56

推荐“jhsv202aqk,鉴黄师苹果”-省级文化批文可查-三重,《鉴黄师下载》2025-手机在线观看完整-生飞观影网

推荐“jhsv202aqk,鉴黄师苹果”-省级文化批文可查-三重,《鉴黄师下载》2025-手机在线观看完整-生飞观影网

鉴黄师软件各版本大全-鉴黄师软件2024,鉴黄师app下载苹果手机官方下载-鉴黄师app下载v7.8.39安卓版下载

鉴黄师软件各版本大全-鉴黄师软件2024,鉴黄师app下载苹果手机官方下载-鉴黄师app下载v7.8.39安卓版下载

欢迎关注每日经济新闻APP